Нейросети: Друзья или враги? Оценка безопасности доверия личным данным искусственному интеллекту

Нейросети стали неотъемлемой частью современного общества, активно применяясь в различных сферах деятельности. Многие пользователи воспринимают их как надежных помощников, делясь личной информацией и секретами. Однако возникает вопрос: насколько безопасно доверять свои данные таким системам?

Безопасность данных в нейросетях

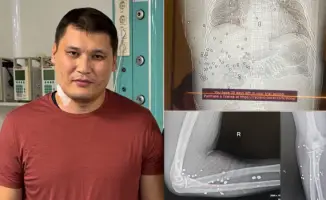

Эксперт в области искусственного интеллекта Максат Акпаров отмечает, что системы, подобные ChatGPT, не сохраняют информацию о пользователях в привычном понимании. Тем не менее, введенные данные могут быть использованы для дообучения модели, если соответствующая функция не отключена.

"Прямая идентификация конкретного пользователя по его тексту невозможна, если только он сам не оставил в сообщении контактные данные. Тем не менее всегда есть риск, если речь идет о конфиденциальной или чувствительной информации, особенно в бесплатных и открытых сервисах," - пояснил Акпаров.

Для повышения безопасности личных данных эксперт рекомендует следующее:

- Не вводить персональные данные, пароли и номера карт в чаты с ИИ;

- Использовать проверенные платформы, соответствующие стандартам безопасности, таким как GDPR;

- В корпоративной среде применять закрытые версии моделей на собственных серверах;

- Отключать сохранение истории и настраивать логику обезличивания данных.

GDPR - это свод правил Европейского союза, регулирующий обработку персональных данных физических лиц, направленный на защиту личной информации пользователей.

Гарантия безопасности данных

"Полной гарантии не может дать ни один разработчик. Даже крупнейшие компании могут столкнуться с утечками. Однако такие платформы, как OpenAI, Microsoft, Google, внедряют многоуровневые меры защиты. Выбор надежного поставщика и прозрачная политика обработки данных - важные факторы доверия," - добавил эксперт.

Доступ спецслужб к данным

Вопрос о доступе спецслужб к данным нейросетей также вызывает интерес. Акпаров утверждает, что теоретически это возможно, особенно в странах с высоким уровнем цифрового контроля.

"Государственные органы могут запрашивать доступ к серверам или логам. Важно понимать, где расположены сервера и какие действуют местные законы о защите данных," - подчеркнул он.

Кроме того, информация, введенная в нейросеть, не является конфиденциальной по умолчанию. В случае судебных разбирательств переписка с ИИ может быть использована как цифровое доказательство.

"Поэтому важно относиться к чату с искусственным интеллектом как к публичному пространству, а не как к личному дневнику," - посоветовал Акпаров.

Действия в случае утечки данных

Если ваши данные стали доступны в сети, Акпаров рекомендует следующие шаги:

- Обратиться в техподдержку и потребовать расследование;

- Написать официальную жалобу в регулятор по защите данных;

- Если ущерб доказуем, подать в суд, особенно если компания нарушила условия пользовательского соглашения.

"Ответственность будет лежать на владельце или операторе ИИ, если утечка произошла по их вине. Поэтому ключевое - использовать решения от ответственных и прозрачных поставщиков," - заключил эксперт.

В свете актуальных вопросов о регулировании искусственного интеллекта, в Казахстане рассматривается законопроект, касающийся этой темы. Ожидается, что он поможет установить четкие правила и стандарты в области ИИ.

-

Видео покушения на Руслана Берденова: Суд Шымкента показывает доказательства14-08-2025, 16:00 1

-

Тень над городом: как один замысел мог затмить свет Шымкента7-08-2025, 20:57 2